人工智能还远未成熟,不该过火监管

你能够用刀来切蔬菜,能够用它来抹黄油,但你也能够用它来做 harakiri 或谋杀其别人。但若是刀的第一个创造者被告知“我们需要标准那一点,因为人们能够用它来杀死本身或杀死别人”,那么人类将承受庞大丧失。

人工智能是什么?人工智能(Artificial Intelligence,AI)是研究、开发用于模仿、延伸和扩展人的智能的理论、办法、手艺及应用系统的一门新的手艺科学。它是计算机科学的一个分收,它诡计领会智能的本色,并消费出一种新的能与人类智能类似的体例做出反响的智能机器,该范畴的研究包罗机器人、语言识别、图像识别、天然语言处置和专家系统等。

人工智能能做什么人工智能就像核科学、基因科学,或者像刀一样不起眼的工具,对人类的益处可能大于危害——它将有助于药物的发现,它将为消费设备中的缺陷检测带来更高的效率,它将使金融市场更有效率,它将为人类腾出大量时间,然后我们能够将那些时间投入到更多依赖人类聪慧的更高和更大的事业上,而不是将时间花在反复的普通使命上。

人工智能的3个阶段:狭义人工智能 (Artificial Narrow Intelligence,ANI)(我们目前获得的功效,像 AlphaGo 如许的单一用处人工智能、主动驾驶汽车,以至像保举系统、深度进修翻译等机器进修模子)通用人工智能 (Artificial General Intelligence,AGI)(尚未实现,在各类使命中与人类程度的才能相婚配的人工智能)超等人工智能(Artificial Super Intelligence,ASI)(尚未实现,在各类使命中超越人类程度的才能)人工智能的危害—不单单是AV换脸今天的人工智能会危险吗?是的!即便不诉诸超等智能,也确实存在一些歹意利用人工智能的办法。例如AV在线换脸,主动驾驶汽车的匹敌性,针对特定人群缺乏公允的决策等。

AI 研究人员关于 AI 可能存在的风险、该风险何时会呈现以及 AI 能否可能构成保存风险存在不合,但很少有研究人员认为 AI 不构成风险。即便在今天,我们也看到狭隘的 AI 加剧蔑视和赋闲问题的迹象,若是我们不采纳恰当的预防办法,我们能够预期问题会恶化,跟着 AI 变得愈加智能和复杂,影响更多人。

人工智能监管源于恐惧关于人工智能监管的大部门讨论起初都源于对“有感知力的人工智能”或“险恶的杀手机器人”的非理性恐惧,而不是对其能做什么和不克不及做什么的更深切的领会。

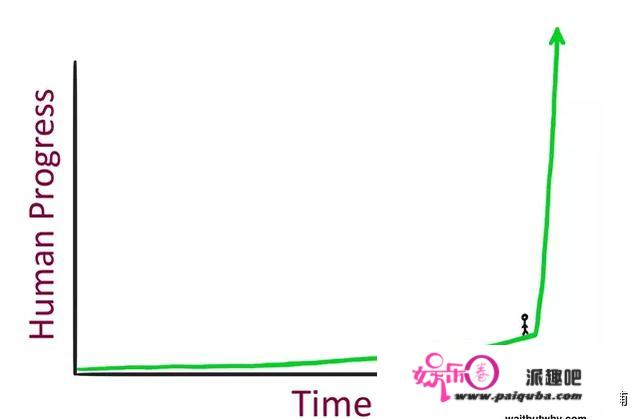

特斯拉公司CEO马斯克担忧 ASI,一旦我们实现 AGI,ASI 就会很快发作,因为它的核心进修才能和思惟的复杂性将呈指数级增长。强化进修手艺进一步促进了那种增长,我们允许 AI 自我训练。

潜在的恐惧在于人工智能能够自我复造和自我改良。若是那是实的,那么最末人工智能机器将变得优于人类。若是发作那种情况,人工智能机器能够判断人类具有毁坏性,并招致灭绝事务将我们覆灭。

想象一下,若是我们让阿尔伯特·爱因斯坦教他年轻时的本身。比及年轻的阿尔伯特长大后,他可能会比他本来的版本更伶俐。然后我们让阿谁阿尔伯特教下一代并反复那个轮回数十亿次。我们在它完毕时得到的将是“常识的爆炸式增长”。

理论上,我们可能会在没有才能控造那种力量的情况下“召唤 ASI 的恶魔”

如今的问题是……我们离 AGI 十分十分远。我们以至还没有接近建造一小我造的阿尔伯特·爱因斯坦,让他与另一个本身的虚拟克隆人辩说相对论。事实上,我们更好的人工智能才能远低于蠕虫级此外智力程度。我们的由大数据根底设备驱动的具有数千个神经元的深度进修模子目前仍然难以区分狗和面包圈。

而蠕虫,则具有单个神经元施行视觉、磁感应等功用。 那与神经元的数量无关(有了足够的硬件,我们能够构建庞大的神经收集),事实上,人工智能存在一个大问题:即便是它的缔造者也无法解释它是若何工做的;我们在生成匹敌收集方面获得了一些停顿,我们让 AI 彼此交换,但我们实的只是处于发现阶段,可能需要数十年的研究才气到达需要监管的接近 AGI 的程度。

阿西莫夫的人工智能定律机器人不得危险人类,或因不做为而招致人类遭到危险。机器人必需从命人类发出的号令,除非那些号令与第必然律相抵触。机器人必需庇护本身的存在,只要那种庇护不与第必然律或第二定律相抵触。人工智能是现代”太空竞赛“AI 开展是那一代人的太空竞赛。任何以过度监管那项手艺做为回应的国度都将在立异方面落后并失败。当您必需适应监管不时,您无法十分有效地开发创始性的系统,即便一个国度积极选择人工智能开发,律例也会从素质上限造停顿。但缺乏监管会带来一系列问题。它能够让 AI 开发变得不那么隆重,并且因为那是人类有史以来开发的更具变化性的手艺,它应该尽可能地隆重。

当爱因斯坦将量能方程推向那个世界时,他的脑海中当然没有广岛或长崎。他的发现不断是核能的收柱,核能已被证明是许多国度的重要能源。

同样,大量的生物研究人员当然不会为了某一天允许地痞社会分子将基因工程流感病毒做为兵器释放到世界上而停止研究。

任何伟大的科学设法城市带来意想不到的副感化。核能会形成良多危险,就像 2011 年日当地震的情况一样。但也许有一天,冷聚变将使人类掌握太阳的力量。

人工智能做为一项根底手艺不该该遭到监管,阻遏您在条记本电脑上施行神经收集似乎也不实在际。然而,人工智能的一些应用,例如主动驾驶,需要监管。人工智能还对反垄断(垄断监管)产生了新的影响,监管机构尚未考虑但应该考虑。因为今天的人工智能还不成熟且开展敏捷,任何国度的严厉监管城市障碍该国的人工智能前进。

一项手艺越有可能对大量人产生适度影响,以至对少数人产生强烈影响,它就越需要“监管”。那显然其实不意味着停行前进。与不存在监管中断的情况比拟,监管最末能够实现更平安、更快地停顿。手艺前进不会主动对社会和小我产生积极影响。我们已经在大大都手艺和非手艺范畴造定了律例。一些明显的例子包罗:您在道路的哪一边行驶,驾驶时限速,哪些药物是处方药,哪些长短处方药,谁能够称本身为博士(那些承受过足够培训的人)。我们有关于药物开发和销售的规定。在 IT 方面,我们对您能够传输的 EM 频次有严酷的规定,以免干扰可能在不异频次上领受或传输的医疗、工业或军事设备。我们以至对加密手艺和算法有出口管束和规定。当然,我们对核质料的利用和分配有严酷的规定。

一些人工智能用例需要监管以庇护小我并加速其接纳。汽车行业已禁受到严酷监管以确保平安。按照主动驾驶等新的人工智能功用,思虑那些监管律例应该若何接纳将有助于整个行业的安康开展,其他范畴也是如斯,包罗造药、军备控造、金融市场等。但是监管应该是针对特定行业的,而且基于对用例的深图远虑以及我们希望/不想在特定行业看到的成果,而不是基于根本手艺。

但我们可能无法造定涵盖“该监管的人工智能”的简单规定,监控或控造流程的困难其实不意味着我们不该该如许做。与控造和平安利用核质料比拟,人工智能有可能对世界产生更普遍、更强大的影响。

当谈到即将呈现的高级人工智能时,我认为我们如今太像蚂蚁一样昂首看着一小我来处理它。

人工智能—乐不雅or灰心?人工智能会产生意想不到的后果,但任何接近那些后果的测验考试都可能遭到对主动化机器的高度恐惧和灰心情感的驱动。

我认为目前最应该遭到监管的是自主兵器。就像核兵器和生物兵器一样,自主兵器显然具有险恶的企图,应该由某些机构彻底制止或监管。但是也存在一个灰色地带,若是我们认为人类的生命不值得在战争中丧生,能否值得允许自主兵器?或者,自主机器人兵士能够代替结合国维和人员。那些是哲学辩说,应该在世界对人工智能做出情感化的决定并障碍人类前进之前停止辩说。

做为一个文明,我们面对的挑战只会越来越大——恶劣的气候形式、天气变革、向受灾地域运送食物和援助——而智能机器可能会成为我们在那场战斗中更好的伴侣和盟友。

我来回答